La fabrique des subalternes: les LLM, la différence homme-machine et le mythe de l'originalité

Depuis le lancement de ChatGPT, le 30 novembre 2022, l’espace public se remplit de discours sur l’IA, le rapport humain/machine et une série d’angoisses de différentes sortes. Les institutions d’enseignement, par exemple, semblent terrorisées devant les changements qu’apporterait un tel outil. Cet intérêt immense pour un objet somme toute assez anodin – un agent conversationnel… – révèle sans doute, en premier lieu, le grand succès du coup de publicité d’openAI – la mise à disposition de Bard au grand public a fait beaucoup moins de bruit –, mais c’est aussi un signe de quelque chose d’autre: une peur effrénée de voir menacée la place de “l’homme” dans le monde. J’utilise volontairement le masculin, car, comme je vais essayer de montrer, ce qui nous angoisse dans les LLM est le fait qu’ils semblent miner des stratégies discursives qui permettent de créer des dispositifs hiérarchiques où l’on définit de façon claire une séparation entre dominants (d’où la cohérence du masculin) et dominés.

ChatGPT semble en effet avoir des capacités que, normalement, nous identifions comme étant caractéristiques d’une élite: manipuler de façon correcte la langue naturelle, sans faire de fautes, produire des discours “originaux”, faire preuve de “créativité”. En ce qui concerne le français, en particulier, la forme même de la langue, avec une orthographe complexe qui ne peut être déduite de l’oral, a pour vocation de produire des élites – qui seront capables de maîtriser cet objet complexe – et des subalternes – qui ne seront pas en mesure de le faire. Mais que se passe-t-il si un simple algorithme, une “machine”, arrive à réaliser cette prouesse mieux qu’un dirigeant? Ou, même, mieux qu’un littéraire? Une compétence qui était utilisée pour produire une hiérarchie ne peut plus l’être. D’où notre énorme angoisse. Ce qui est menacé par les LLM, ce n’est pas la spécificité des humains face à la froideur des machines, mais la tranquillité des élites qui voient s’amincir le fossé qui les sépare de la masse des subalternes.

Voici donc mon hypothèse de fond: les stratégies discursives de définition de l’humain en opposition à quelque chose d’autre – comme les animaux, les automates ou les machines – sont de fait, toujours et avant tout, des stratégies de production de hiérarchies sociales, culturelles et, plus génériquement, symboliques qui peuvent être comprises comme une véritable fabrique des subalternes.

Les LLM ont fait exploser la visibilité de ces stratégies dans les différents discours à propos de l’intelligence artificielle qui tendent presque systématiquement à définir des “limites” de la machine dans l’objectif véritable d’affirmer une prétendue supériorité humaine.

C’est ce qui s’exprime très souvent dans des phrases comme: “Et ça, une machine ne pourra jamais le faire…”.

Il est assez intéressant de remarquer que Turing, dans son fameux article de 1950, avait déjà traité ce type d’objections, en les appelant “arguments à partir de différentes incapacités”. Voici le texte de Turing:

Arguments from Various Disabilities. These arguments take the form, “I grant you that you can make machines do all the things you have mentioned but you will never be able to make one to do X”. Numerous features X are suggested in this connexion. I offer a selection: Be kind, resourceful, beautiful, friendly (p. [454]), have initiative, have a sense of humour, tell right from wrong, make mistakes (p. [454]), fall in love, enjoy strawberries and cream (p. [453]), make some one fall in love with it, learn from experience (pp. [460]f.), use words properly, be the subject of its own thought (pp. [454–5]), have as much diversity of behaviour as a man, do something really new (pp. [455–6]). (Some of these disabilities are given special consideration as indicated by the page numbers.) No support is usually offered for these statements. I believe they are mostly founded on the principle of scientific induction. A man has seen thousands of machines in his lifetime. From what he sees of them he draws a number of general conclusions (Turing 1950).

La stratégie est assez drôle – et tout à fait bien saisie et décrite par le mathématicien britannique: il s’agit de déplacer l’attention pour chercher quelque chose que “la machine” ne saurait pas faire. Or le problème est que, évidemment, devant une machine, on trouvera toujours quelque chose qu’elle ne sait pas faire, car il s’agit d’une machine. Je peux aussi regarder attentivement un être humain et trouver quelque chose qu’iel ne sait pas faire (moi, je ne sais pas parler russe, par exemple) . De la même manière, je peux regarder un LLM – GPT ou Palm, par exemple – et dire qu’il n’est pas capable de discerner ce qui est vrai de ce qui ne l’est pas. En ce moment, cette activité semble être le sport national des journalistes, qui continuent à faire des “expériences” pour montrer que ChatGPT ou Bard disent des choses fausses (cf. par exemple ici ou ici, ou ici)… Or bien sûr que ces algorithmes disent des choses fausses! Il n’y a pas besoin de faire des “expériences” et des “études” pour savoir ça! Le modèle sur lequel ils sont basés n’implémente aucune idée de vérité… Les LLM sont des modèles construits pour être capables de produire des phrases correctes et non pour avoir un contrôle sur le contenu de ces phrases. Aucune notion de vérité, donc, et aucune possibilité de vérifier quoi que ce soit. Mais cela n’est pas une “limite” des “machines”. C’est juste une caractéristique du modèle qui n’est tout simplement pas fait pour savoir ce qui est vrai, mais pour être capable de manipuler la langue naturelle. On peut avoir d’autres algorithmes – même beaucoup plus simples – qui connaissent la vérité et qui sont capables de donner seulement des informations vérifiées et acceptées, par exemple, par une communauté scientifique. Demandez la liste des livres de Proust au catalogue d’une bibliothèque nationale et cette liste sera absolument correcte. S’écrier devant le fait que ChatGPT donne des informations fausses c’est comme s’étonner parce que notre cafetière ne nous montre pas une série Netflix, ou parce que Google Search ne sait pas faire de pain.

À chaque fois qu’on dit: “et ça, une machine ne pourra jamais le faire”, nous mettons en place une double triche. En premier lieu, celle identifiée par Turing: nous induisons, sur la base des machines que nous connaissons – et souvent en nous limitant aux machines que nous avons devant les yeux – que “toutes les machines” ont les mêmes caractéristiques. Puisque ChatGPT ne peut pas aimer les fraises et la glace, alors les machines ne sauront jamais aimer les fraises et la glace. Mais le problème est qu’il peut exister d’autres modèles computationnels qui implémentent l’idée du plaisir de la glace! En second lieu, nous donnons souvent une définition très floue de ce “ça” que les machines ne sauraient pas faire. C’est typiquement la stratégie de Searle dans son expérience de la chambre chinoise: la syntaxe (ce que les machines savent faire) est définie de façon très précise; le sens (ce que les machines ne sauraient pas faire et qui serait donc “propre à l’homme”) n’est pas défini du tout: on renvoie juste à une compréhension vague et soit disant “commune” de ce que le sens est.

Et, chez Searle, l’objectif est vraiment évident: il faut affirmer la supériorité humaine. C’est une sorte de “doxa humaniste”: il faut préserver la singularité humaine de la menace d’une déshumanisation qui serait causée par les machines. Mais derrière cette doxa humaniste se cache en réalité une stratégie de domination consistant à structurer la distribution de la valeur symbolique pour faire en sorte de garantir des hiérarchies stables qui confortent – fondamentalement – le statut des élites et leur pouvoir.

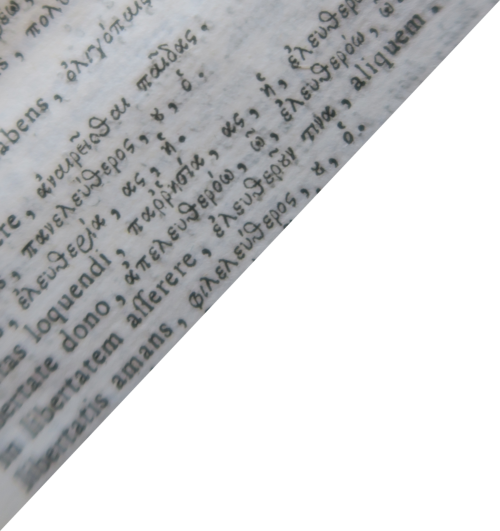

Selon cette doxa humaniste, il y aurait des caractéristiques proprement humaines, qui définissent de façon claire l’essence de l’humain en le différenciant de manière nette et claire du reste des choses. C’est une idée qui a toujours été présente dans la pensée occidentale, à partir des grecs, notamment avec des notions telles que ζῶον πολιτικόν (animal politique) ou ζῶον λόγον ἔχον (animal doté de langage ou de raison). Les êtres humains seraient différents et bien identifiables.

Mais ces caractéristiques qu’on essaie de définir comme “essentielles” en réalité se déplacent et changent tout le temps… c’est justement ce que nous révèle l’adagio “et ça, une machine ne pourra jamais le faire”: le référent du “ça” change à chaque fois. Nous trouvons une machine qui sait tisser? Nous disons que les machines ne pourront jamais parler. Nous trouvons une machine qui sait parler? Nous disons qu’elles ne pourront jamais faire de la poésie. Nous trouvons une machine qui fait de la poésie? Nous disons qu’elles ne pourront jamais avoir de l’humour. Une machine a de l’humour? C’est l’intentionnalité qui lui manque… Et cette chose, ce “ça” toujours différent, devient la nouvelle spécificité des êtres humains.

La stratégie est claire: nous voulons montrer notre supériorité.

Une remarque intéressante, qui m’a été suggérée par Jean Dhombres: dans certains livres de mathématiques et de géométrie du XVII^e^ siècle (notamment un commentaire aux Éléments d’Euclide), on trouve des illustrations de naufragés qui arrivent sur une plage et, en voyant des figures géométriques tracées sur le sol, s’exclament: “Bene speremus, hominum enim vestigia video” (Soyons confiants, je vois des traces humaines).

Dans ce cas, la caractéristique typiquement et essentiellement humaine était la capacité de faire de la géométrie et des mathématiques. Cette image est particulièrement parlante: ce que veulent dire les naufragés, en effet, ce n’est pas tellement qu’il y a des animaux appartenant à l’espèce humaine sur la terre où ils se sont retrouvés, mais, plus précisément, qu’il y a des êtres humains “civilisés”, à savoir des blancs, des occidentaux, et non des “sauvages”. Dans la bonne tradition de l’imaginaire des grandes découvertes, la question est justement là. La géométrie est une caractéristique essentielle de “l’homme” car elle permet de faire la différence entre des êtres supérieurs et des êtres inférieurs, des dominants et des dominés. D’une part les colons occidentaux avec leur civilisation, de l’autre tout le reste: choses inanimées, animaux et être humains qui ne partagent pas la même culture.

Le fait de dire que la capacité de faire de la géométrie est propre à l’humain est en réalité une stratégie pour justifier la colonisation et pour créer des subalternes: nous avons le droit de vous dominer, car vous êtes moins humains que nous, comme le démontre le fait que vous n’avez pas de compétences géométriques ou mathématiques.

Ce qui est drôle – si on peut encore sourire devant cette immense violence – est que, si dans un roman contemporain, on naufrageait sur une île où l’on trouvait des traces de figures géométriques, on pourrait se dire que c’est peut-être une île habitée par des machines. Les “machines” sont évidemment bien meilleures que les êtres humains en mathématiques. La capacité de compter et de calculer ne peut certes plus être utilisée comme trait caractéristique d’une élite – c’est d’ailleurs pour cette raison que la tâche de compter était laissée aux femmes au début de l’informatique et que “les premiers computers étaient des femmes” comme le dit Jennifer Light… (When Computers Were Women).

Ce que démontre cet exemple est que nous mettons toujours à nouveau en place des stratégies pour trouver un “ça”, une caractéristique qui permette d’identifier et de délimiter une élite en la distinguant de manière forte de la masse. Mais l’exemple démontre aussi que ce “ça” ne peut pas rester toujours le même. Il faut donc le déplacer.

Ce qui nous dérange des LLM est qu’ils semblent avoir des capacités qui ont longtemps servi à caractériser des élites. Tant qu’on automatise des tâches réservées à des subalternes, il n’y a pas de problèmes, car l’automatisation aide et rend efficace le mécanisme de fabrique des subalternes. L’automatisation de compétences manuelles – tisser, justement, ou moissonner –, avec la première révolution industrielle, a contribué à renforcer la séparation entre les élites – qui possèdent les machines et les capitaux – et les subalternes qui ne possèdent que leur force de travail désormais concurrencée par la force de travail des automates. Mais lorsqu’un algorithme semble être capable de faire ce que normalement est une activité de l’élite, alors là… on a peur.

Les différents rapports sortis ces dernières années sur les types de travail menacés par l’automatisation révèlent, encore une fois, cette stratégie de fabrique des subalternes. Dans leur rapport de 2013 (The future of employment: how susceptible are jobs to computerisation?), Frey et Osborne rassuraient les élites en affirmant:

The expansion in high-skill employment can be explained by the falling price of carrying out routine tasks by means of computers, which complements more abstract and creative services.

Les tâches des subalternes seront de plus en plus dévalorisées (et dévalorisables), car on peut les automatiser. Mais, rassurez-vous, cadres supérieurs, dirigeants, managers, grands intellectuels: vos jobs ne sont pas à risque car vous êtes plus humains que vos subalternes. Eux, ils peuvent être remplacés, pas vous!

Quelques années plus tard, les dirigeants sont moins tranquilles: le rapport de 2023 du World Economic Forum (Future of Jobs Report) nous dit:

But while expectations of the displacement of physical and manual work by machines has decreased, reasoning, communicating and coordinating – all traits with a comparative advantage for humans – are expected to be more automatable in the future.

Aïe aïe aïe! On croyait pouvoir continuer à disqualifier les tâches traditionnellement attribuées aux subalternes, mais les LLM semblent renverser la donne: on peut automatiser la rédaction d’un courriel très bien écrit, diplomatique, politiquement correct, on peut – chers et chères collègues – automatiser l’écriture d’une demande de financement, et même l’écriture d’un joli poème, la lecture et le résumé d’un texte complexe, l’écriture d’un rendu pour un examen universitaire… mais on ne peut pas automatiser la tâche de refaire un lit.

Nous sommes obligés de constater que les stratégies de production des subalternes tels qu’elles se sont stabilisées dans les derniers siècles – en particulier à partir de la première révolution industrielle – commencent à être en crise. Les changements sociaux, culturels et techniques font en sorte que les valeurs symboliques qui tiennent une société se restructurent. La cause n’en est sans doute pas juste une poignée d’algorithmes. Elle est beaucoup plus profonde. Si l’on pense aux textes sur la fin du concept moderne d’auteur d’un Foucault ou d’un Barthes dans les années 1970, on peut facilement comprendre que le statut symbolique associé à la capacité de gribouiller des phrases et à la production d’une figure comme celle de l’Auteur, fondée sur la notion d’originalité, sont en crise depuis au moins un demi siècle. ChatGPT ne provoque pas cette crise, il la confirme.

Devant cette crise – qui n’a rien d’une révolution, mais qui est plutôt un long et lent changement progressif des valeurs qui fondent nos sociétés occidentales – nous avons deux possibilités. La première, la plus simple et celle qui va sans doute se réaliser, est de modifier les stratégies de fabrique des subalternes, d’identifier de nouvelles caractéristiques pour définir les élites et des nouvelles tâches à attribuer à des subalternes. Suivons les rapports sur le futur du travail et faisons en sorte que les privilégiés puissent rester tels en choisissant de nous concentrer sur des capacités particulières, qui ne sont pas automatisables – pour le moment – ou bien que l’on décide de ne pas vouloir automatiser.

L’autre possibilité serait de se rendre compte de l’énorme mensonge qui couvre ces stratégies. Nous devrions arrêter de croire qu’il y a quelque chose comme une “essence” humaine et nous interroger sur les raisons politiques réelles qui nous poussent encore et encore à déclarer: “et ça, une machine ne pourra jamais le faire”. Avec des Karen Barad, Katherine Hayles, Rose Braidotti, nous pourrions nous poser la question des raisons pour lesquelles “la frontière entre humain et machine se stabilise et se déstabilise” (Barad, Meeting the universe halfway), comment et pourquoi cette frontière se définit d’une certaine manière. Nous pourrions ainsi nous rendre compte qu’il n’y a pas une hiérarchie dans l’émergence du sens: que les “petites mains” – comme les appelle Margot Mellet – ne sont pas petites.

Pour mieux expliquer avec un exemple: dans la rhétorique courante – qui justement est apte à fabriquer des subalternes – dans le monde de l’édition littéraire, il y a:

- Un auteur (masculin): grand penseur, c’est lui le génie, il produit du sens, il est original, il sait écrire, il maîtrise la langue et l’orthographe.

- Une foule de petites mains. Subalternes, presque toujours femmes. Elles font des petites tâches sans valeur symbolique, comme par exemple corriger les coquilles du grand Auteur – qui ne dérivent pas d’un manque de maîtrise, bien sûr, mais juste de sa distraction, ou de “fautes de frappe” (je sais comment ça s’écrit, j’ai juste mal placé mon doigt).

- Une série d’appareils techniques, économiques, sociaux et politiques neutres – formats, protocoles, logiciels, instruments d’impression, condition économiques, cercles littéraires, prix, etc.

C’est un peu la caricature de ce que dénonce Bourdieu au début des Règles de l’art. Une abstraction complète de ce qu’est la littérature, faite juste aux fins de pouvoir produire une figure d’élite, l’auteur.

L’alternative est de se rendre compte que l’Auteur n’a pas plus de mérite, dans la production du sens, que tous les autres éléments en jeu: du format docx à la petite main qui corrige la coquille ou qui colle le dos de la couverture. Non seulement l’auteur n’a pas plus de mérite que la matérialité d’une page de papier, mais surtout l’auteur est le résultat du processus et non l’acteur qui le déclenche. L’auteur est le résultat de l’ensemble des dynamiques mises en place pour produire de la littérature. Il en est, lui aussi, le produit et non le producteur. Et dans ce processus, ce qui compte le plus, c’est de produire des subalternes, pour protéger des élites, de différencier la secrétaire de la maison d’édition du génie littéraire du grand Auteur.

Au lieu de nous préoccuper parce qu’il y aura des textes écrits par des algorithmes (comme si vraiment les textes pouvaient être autre chose qu’une combinaison de mots…), on pourrait commencer à s’interroger sur le rôle qu’un format comme docx a dans le lissage de tout ce que nous écrivons depuis des décennies. Ou sur l’importance capitale de toutes les personnes qui depuis des siècles sont dans l’ombre et pourtant produisent du sens, toutes les petites mains, les computers, les tisseuses, les femmes qui encodent l’index thomisticus… Au lieu de faire des chartes pour éviter l’utilisation des LLM dans le cadre des travaux universitaires (ah! le plagiat! l’importance de l’originalité!), on pourrait comprendre que cette grande valeur que nous attribuons à l’originalité n’est qu’un leurre dont le seul objectif est de produire des subalternes (les non-créatifs, les non-originaux, ceux qui remplissent des fonctions triviales). Il faudrait en même temps se rendre compte que les “fonctions triviales” ne sont pas triviales du tout et qu’au contraire elles sont centrales dans la production du sens. Et peut-être faire des chartes sur l’usage de logiciels comme Word, ou des correcteurs orthographiques, ou des outils de gestion bibliographique, ou des outils pour gérer l’attribution des horaires des cours (CHAL à l’UdeM… outil dont on n’a pas discuté, car il se voudrait “neutre” et juste “efficace”).

Le sens est le résultat d’un ensemble de dynamiques complexes et non hiérarchisables. La hiérarchisation – qui fonde les discours à propos des “différences” homme-machine – n’est qu’une stratégie pour rendre la plus efficace possible la fabrique des subalternes.